Laut einem neuen Bericht, der am Montag vom Internet Observatory der Stanford University veröffentlicht wurde, droht eine neue Flut von durch künstliche Intelligenz generiertem Material über sexuellen Kindesmissbrauch die Behörden zu überfordern, die bereits durch veraltete Technologien und Gesetze gelähmt sind.

Im vergangenen Jahr haben neue Technologien der künstlichen Intelligenz es Kriminellen erleichtert, explizite Bilder von Kindern zu erstellen. Jetzt warnen Stanford-Forscher, dass das National Center for Missing and Exploited Children, eine gemeinnützige Organisation, die als zentrale Koordinierungsstelle fungiert und den Großteil ihrer Mittel von der Bundesregierung erhält, nicht über die Ressourcen verfügt, um die wachsende Bedrohung zu bekämpfen.

Die 1998 gegründete CyberTipline der Organisation ist die bundesstaatliche Clearingstelle für alle Meldungen über Material zum sexuellen Missbrauch von Kindern (CSAM) im Internet und wird von den Strafverfolgungsbehörden zur Aufklärung von Straftaten genutzt. Doch viele der erhaltenen Ratschläge sind unvollständig oder voller Ungenauigkeiten. Auch das kleine Personal hat Mühe, mit der Größe Schritt zu halten.

„Es ist fast sicher, dass CyberTipline in den kommenden Jahren mit hyperrealistisch aussehenden KI-Inhalten überschwemmt wird, was es für die Strafverfolgungsbehörden schwierig machen wird, echte rettungsbedürftige Kinder zu identifizieren“, sagte Shelby Grossman, Co-Autor der Studie. Berichtsautoren.

Das National Center for Missing and Exploited Children steht an vorderster Front in einem neuen Kampf gegen sexuell ausbeuterische Bilder, die mithilfe künstlicher Intelligenz erstellt wurden, einem aufstrebenden Kriminalitätsbereich, den Gesetzgeber und Strafverfolgungsbehörden immer noch identifizieren. Genau genommen, Inmitten einer Epidemie von Nacktfotos, die durch tiefe künstliche Intelligenz erzeugt werden Es wird in Schulen verbreitet und einige Gesetzgeber ergreifen Maßnahmen, um sicherzustellen, dass dieser Inhalt als illegal gilt.

KI-generierte Bilder von sexuellem Kindesmissbrauch sind illegal, wenn sie echte Kinder zeigen oder wenn Bilder von echten Kindern zum Trainieren der Daten verwendet werden, sagen Forscher. Laut einem der Autoren des Berichts können manipulierte Bilder, die keine echten Bilder enthalten, jedoch als freie Meinungsäußerung geschützt werden.

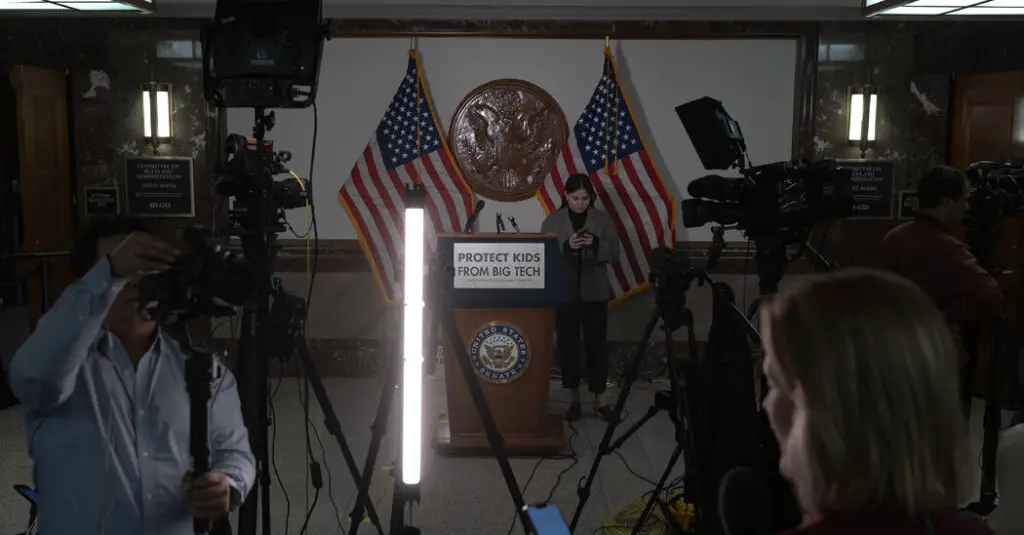

Die öffentliche Empörung explodierte, als Bilder von sexuellem Kindesmissbrauch im Internet verbreitet wurden Eine aktuelle Hörsitzung mit den CEOs von Meta, Snap, TikTok, Discord und Xden der Gesetzgeber dafür kritisiert hat, dass er nicht genug unternimmt, um kleine Kinder im Internet zu schützen.

Das Zentrum für vermisste und ausgebeutete Kinder, das von Einzelpersonen und Unternehmen wie Facebook und Google beraten wird, hat eine Gesetzgebung gefordert, um seine Finanzierung zu erhöhen und ihm Zugang zu mehr Technologie zu ermöglichen. Forscher der Stanford University sagten, die Organisation habe für den Bericht Zugang zu Interviews mit Mitarbeitern und ihren Systemen bereitgestellt, um Schwachstellen in Systemen aufzuzeigen, die aktualisiert werden müssten.

„Im Laufe der Jahre haben sich die Komplexität der Berichte und die Schwere der Verbrechen gegen Kinder immer weiter entwickelt“, heißt es in einer Erklärung der Organisation. „Daher führt die Nutzung neuer technologischer Lösungen im Rahmen der Operation CyberTipline dazu, dass mehr Kinder geschützt werden und Täter zur Verantwortung gezogen werden.“

Forscher der Stanford University haben herausgefunden, dass die Organisation die Art und Weise, wie sie ihre Meldestelle betreibt, ändern muss, um sicherzustellen, dass die Strafverfolgungsbehörden Meldungen erkennen können, die KI-generierte Inhalte enthalten, und um sicherzustellen, dass Unternehmen, die potenzielles Missbrauchsmaterial auf ihren Plattformen melden, Formulare vollständig ausfüllen.

Weniger als die Hälfte aller Meldungen an CyberTipline waren im Jahr 2022 „umsetzbar“, entweder weil die Unternehmen, die den Missbrauch meldeten, keine ausreichenden Informationen lieferten oder weil sich das Bild im Hinweis schnell online verbreitete und mehrfach gemeldet wurde. In der Tipp-Zeile gibt es eine Option, um zu überprüfen, ob der Inhalt des Tipps ein potenzielles Meme ist, aber viele nutzen diese nicht.

An einem einzigen Tag Anfang des Jahres erreichte die Bundes-Clearingstelle eine Rekordzahl von 1 Million Meldungen über Material zum sexuellen Missbrauch von Kindern. Wochenlang arbeiteten die Ermittler daran, auf den ungewöhnlichen Anstieg zu reagieren. Es stellte sich heraus, dass viele der Berichte mit einem Bild in einem Meme verknüpft waren, das die Leute plattformübergreifend teilten, um ihre Wut auszudrücken und nicht böswillige Absichten. Aber es verschlingt immer noch erhebliche Ermittlungsressourcen.

Dieser Trend werde sich mit zunehmender Verbreitung von KI-generierten Inhalten verstärken, sagte Alex Stamos, einer der Autoren des Stanford-Berichts.

„Eine Million identischer Bilder ist schon schwer genug, und eine Million separate, von der KI generierte Bilder werden es zerstören“, sagte Herr Stamos.

Dem Center for Missing and Exploited Children und seinen Auftragnehmern ist es untersagt, Cloud-Computing-Anbieter zu nutzen, und sie sind verpflichtet, Bilder lokal auf Computern zu speichern. Die Forscher fanden heraus, dass diese Anforderung es schwierig macht, die spezielle Hardware zu bauen und zu verwenden, die zum Erstellen und Trainieren von KI-Modellen für ihre Untersuchungen verwendet wird.

Die Organisation verfügt in der Regel nicht über die Technologie, um Gesichtserkennungssoftware in großem Umfang zur Identifizierung von Opfern und Tätern einzusetzen. Ein Großteil der Berichtsverarbeitung erfolgt immer noch manuell.